Содержание:

- Правильный robots.txt и его важность

- Принцип действия и настройка robots.txt

- Закрыть сайт от индексации? Нет ничего проще!

- Настройка robots.txt. 10 важных фишек

Правильный robots.txt и его важность

Хотите узнать как закрыть сайт от индексации поисковиками, когда Вы в этом не нуждаетесь?

Оказывается, это не так уж сложно. Потребуется лишь правильный robots.txt, размещенный в корневой папке Вашего веб-ресурса.

Ну а теперь по порядку.

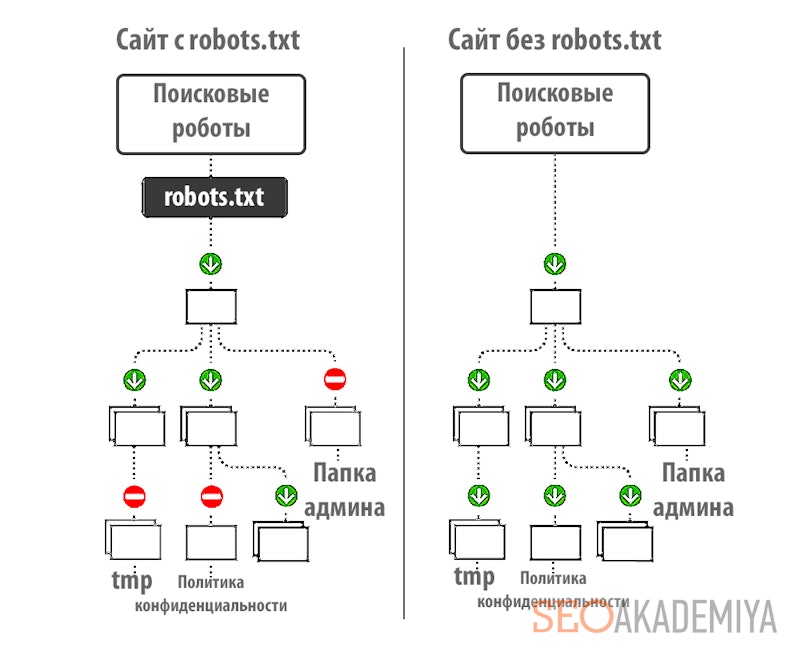

robots.txt – текстовый файл, в котором предписываются рекомендации для действий роботов поисковиков. Именно его они первым делом ищут, едва «переступив порог» Вашего веб-ресурса. Если его нет или он присутствует, но не содержит в себе никакой информации, поисковые боты воспринимают это как разрешение «прогуляться» по всему сайту без каких-либо ограничений.

И наоборот, если в нем прописаны определенные инструкции по запрещению индексации, поисковые роботы будут стараться их придерживаться.

Принцип действия и настройка robots.txt

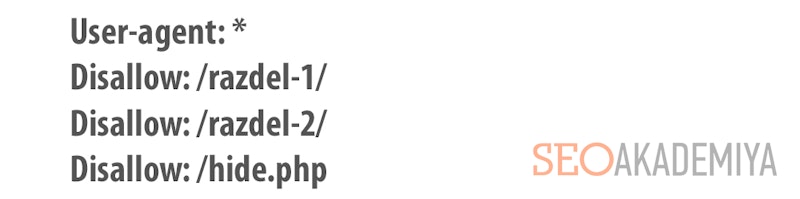

Правильный robots.txt содержит в своем теле записи, каждая из которых начинается со строки, в которой указывается клиентское приложение User-agent. В нем прописывается название робота, к которому относятся инструкции в следующей строке/строках.

Если же инструкция относится ко всем паукам-индексаторам, вместо имени используется символ «звездочка»:

Далее прописывается строка с директивой Disallow и несколько спец. символов, которые выбираются в зависимости от цели инструкции.

Закрыть сайт от индексации? Нет ничего проще!

Собственно говоря, основная функция robots – запретить индексацию. Чего именно? Тут уж Вам выбирать. Вариантов существует предостаточно:

- Полностью запретить индексацию сайта. Подразумевается возможность отказать пришедшему «в гости» роботу заходить на Ваш веб-ресурс и выполнять свою работу. Может быть полезно на ранних стадиях разработки сайта, когда публикация контента уже началась, но еще не доведена до нужного уровня. В этом случае индексация неоптимизированных страниц нежелательна, дабы «не подпортить» заранее репутацию сайта.

- Закрыть от индексации раздел/категорию. Используется в случае вполне действующего веб-ресурса, имеющем определенный рейтинг в глазах поисковиков, когда готовится новый раздел или категория, индексация которых пока что нежелательна.

- Запретить индексацию страницы. Удобно использовать в случае, если на сайте размещены документы, которые нужны, но не должны индексироваться и влиять на общий рейтинг веб-ресурса. Например, это может быть «Политика конфиденциальности», состоящая из неуникального текста.

Настройка robots.txt. 10 важных фишек

- Если в robots запретить индексацию, то она будет действовать по принципу старшинства. То есть запрет распространяется на все файлы, страницы и директории, которые подчинены указанному элементу.

- Правильный robots.txt всегда содержит минимум одну строку User-agent, чтобы его принимали к сведению.

- Возможна настройка robots.txt, при которой для одного бота может быть прописана запись, состоящая сразу из нескольких инструкций.

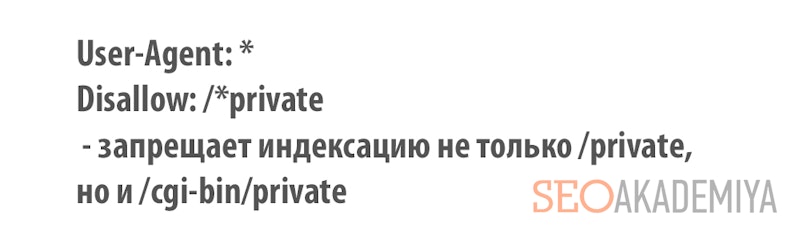

- Символ «*» перед названием поможет запретить индексацию всех объектов с указанным словом.

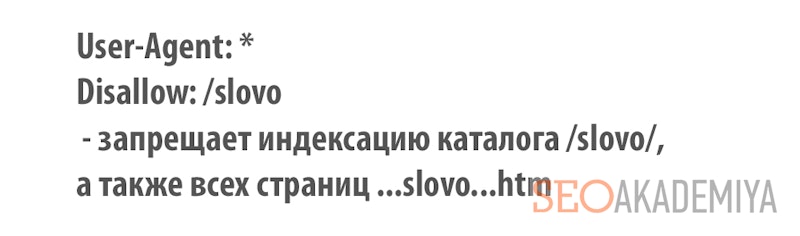

- Символ «/» используется как в начале, так и в конце названия директории. В противном случае robots может запретить индексацию всех страниц, в имени которых встречается «slovo».

- Пустая директива Disallow дает роботу разрешение индексировать все странички веб-ресурса.

- Желательно, чтобы правильный robots.txt указывал, где находится карта сайта. Это значительно ускорит индексацию страниц и исключит вероятность случайного пропуска роботом некоторых из них.

- Правильный robots.txt может содержать инструкции, прописанные только при использовании нижнего регистра.

- Любая Disallow может указывать только на один файл/раздел/страницу и должна прописываться с новой строки.

- Нельзя прописывать сначала Disallow, а потом User-agent. Подобная настройка robots.txt будет пустой тратой времени, поскольку боты не смогут понять таких инструкций.

И самое главное правило – перед тем, как залить правильный robots.txt в корень веб-сайта, нужно убедить в его правильности. Рекомендуется проверять его на ошибки несколько раз. А еще лучше – дать проверить кому-нибудь другому. Свежему взгляду проще будет увидеть опечатки и прочие неприятности в теле файла.

Только верная настройка robots.txt поможет запретить индексацию именно тех элементов Вашего сайта, которые Вы пока что решили скрыть от «зоркого взгляда» поисковиков.

Остались вопросы? Задавайте! Ждем Вас в комментариях!

Павел Шульга

Павел Шульга