зміст:

- Як виявити і виправити помилки в файлі robots.txt

- Найчастіші помилки файлу robots.txt

- Принципи, яким потрібно слідувати, щоб запобігти помилкам у файлі robots.txt

- Перевірка robots.txt на помилки

Як виявити і виправити помилки в файлі robots.txt

Кожен поважаючий себе веб-майстер повинен мати хоча б загальне уявлення про те, як управляти процесом індексації сторінок і файлів сайту в пошукових системах.

Не будемо тягнути гуму і відразу відзначимо, що для знаходження спільної мови з пошуковими роботами досить правильно налаштувати robots.txt. Ключове слово – « правильно ». Адже якщо допустити в robots.txt помилки, наслідки можуть бути досить неприємними.

Найчастіші помилки файлу robots.txt

- Переплутані значення директив ( через незнання або через недогляд ).

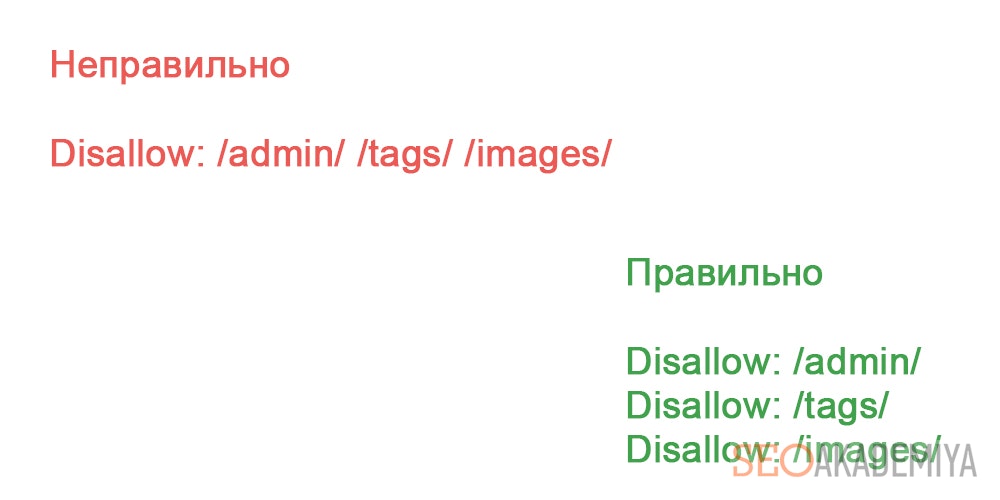

- Перерахування кількох URL в одній директиві Disallow.

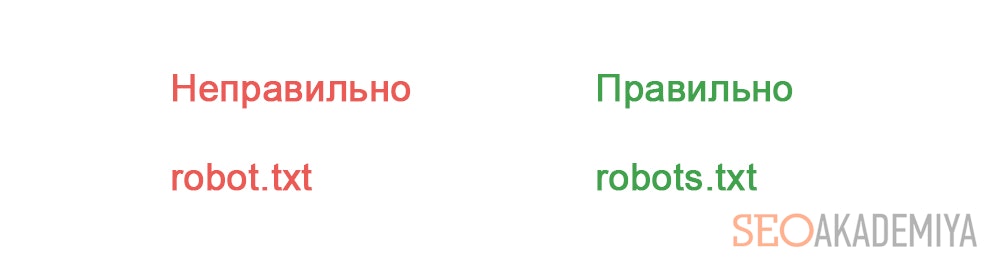

- Назва файлу robots.txt з помилками.

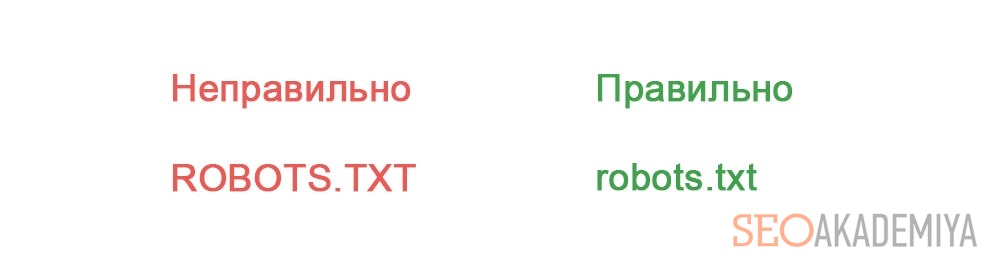

- У назві файлу robots.txt присутні великі літери.

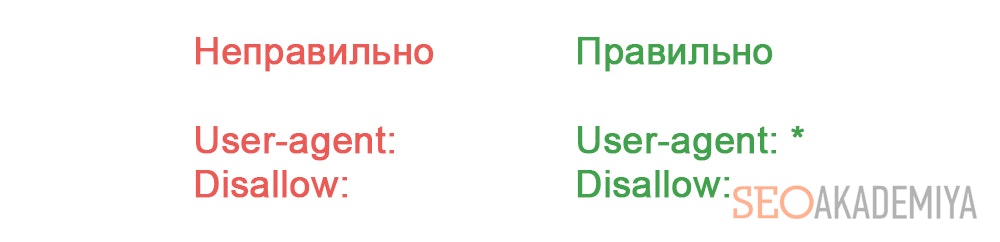

- Порожнє поле в User-agent.

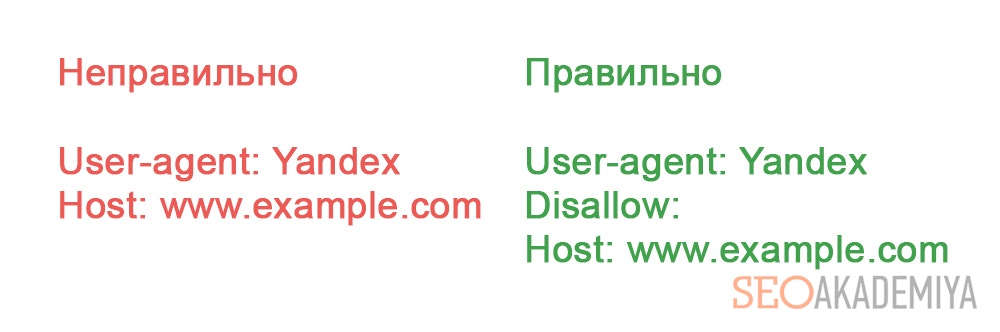

- Відсутня директива Disallow.

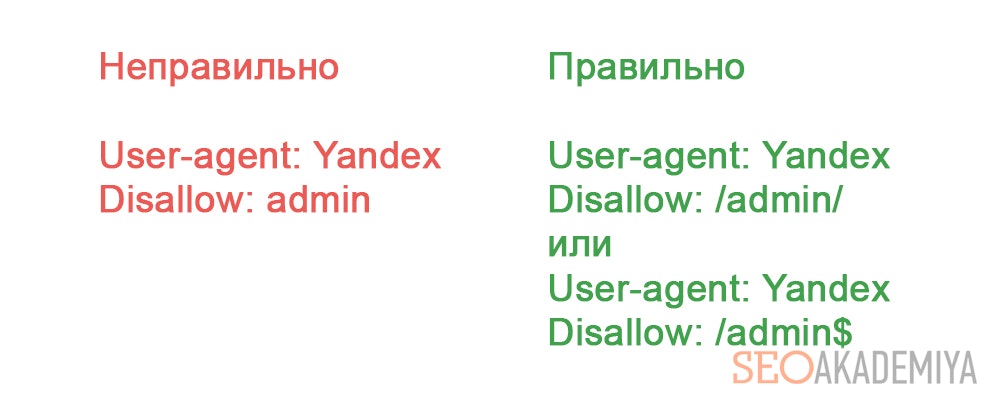

- Неправильний формат URL в директиві Disallow.Ошібка в файлі robots.txt на лівій половині скріншота призведе до того, що від індексації будуть закриті всі сторінки і файли, на початку URL яких міститься « admin ».Все буде вказано правильно, якщо використовувати символи « $ » і « / » для вказівки « розриву ».

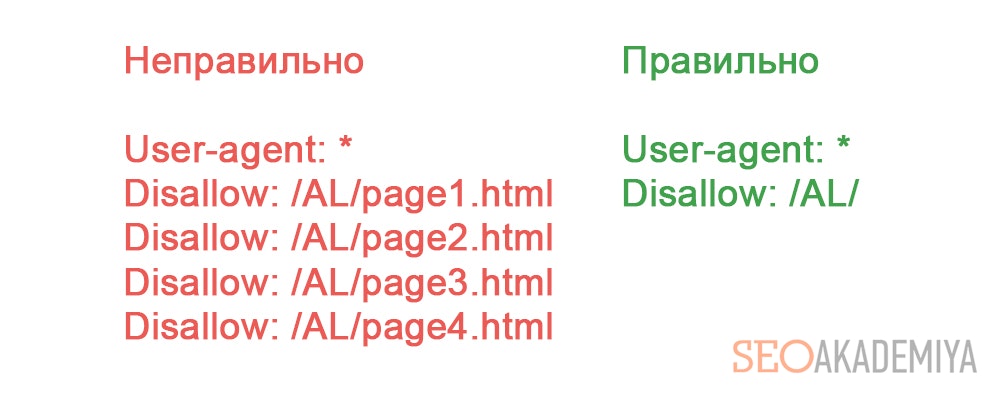

- Перерахування всіх файлів директорії. В принципі це не зовсім помилка. Просто раціональніше в цьому випадку закрити від індексації всю директорію цілком.

Принципи, яким потрібно слідувати, щоб запобігти помилкам у файлі robots.txt

- Прописані в robots.txt директиви є рекомендаціями, яких дотримуються лише роботи великих пошукових систем. Сторонні боти найчастіше на них уваги не звертають. Тому їх краще блокувати по IP.

- Заблоковані в robots.txt сторінки все ще продовжують бути доступними інтернет-користувачам. Тому якщо мета – приховати веб-сторінку не тільки від роботів, але і від користувачів, на неї потрібно встановити пароль.

- Піддомени розглядаються пошуковими системами як окремі сайти. Тому рекомендації по їх індексації слід прописувати в окремих robots.txt в корені кожного піддомену.

- robots.txt нечутливий до регістру. Тому директиви можна писати як малими, так і прописними. Але імена файлів і директорій повинні прописуватися тільки так, як вони виглядають в адресному рядку браузера.

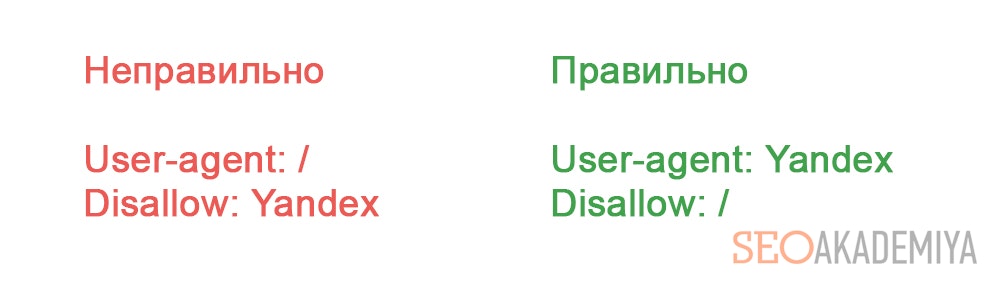

- Зазначений в директиві User-agent реагує на всі зазначені під ним директиви аж до наступного рядка з User-agent. Тому не варто сподіватися, що директиви під другим User-agent будуть виконані роботом, зазначеним в першому User-agent. Для кожного робота вказівки потрібно дублювати.

Перевірка robots.txt на помилки

Щоб перевірити robots.txt на помилки, найпростіше скористатися призначеними для цього інструментами від пошукових систем.

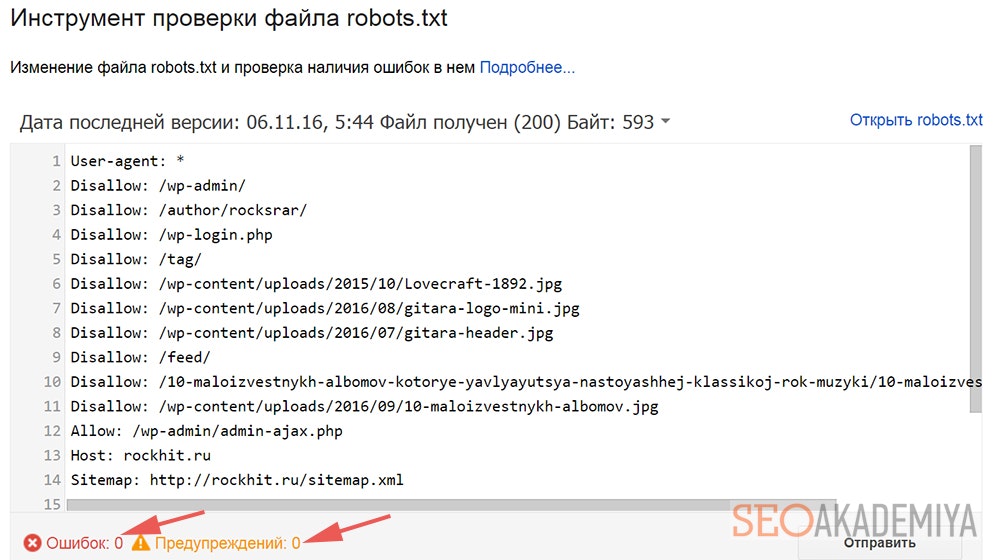

У випадку з Google потрібно зайти в Search Console / Сканування і вибрати « Інструмент перевірки файлу robots.txt ».

Під вікном з вмістом шуканого файлу можна побачити кількість помилок і попереджень.

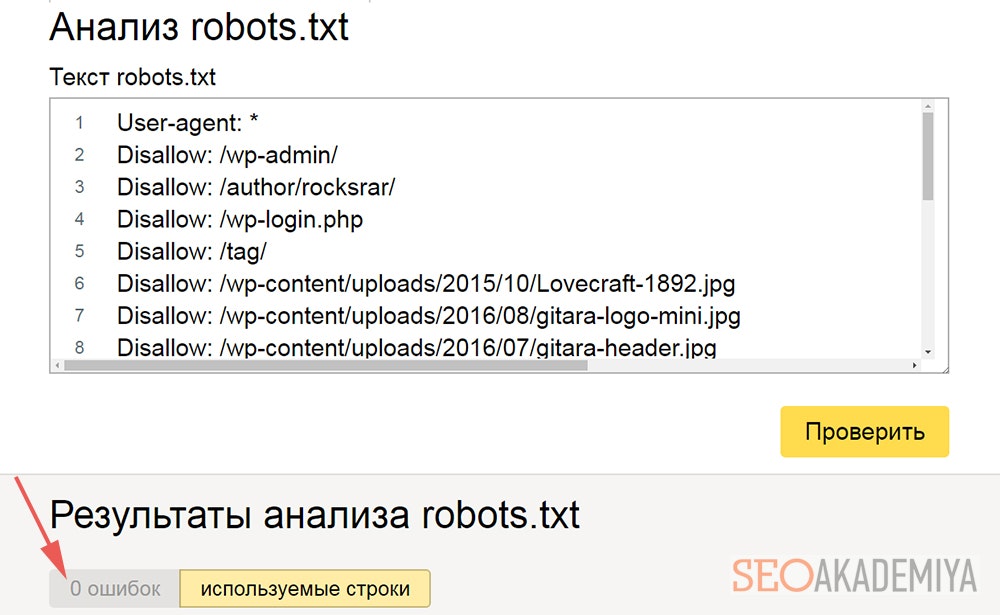

У Яндекс.Вебмастере є аналогічний функціонал ( Інструменти / Аналіз robots.txt ).

Також є можливість дізнатися, скільки в перевіряється robots.txt помилок.

Правда, якщо обидві перевірки покажуть, що помилок немає, це ще не привід радіти. Це лише означає, що прописані в файлі інструкції відповідають стандартам.

Але в ньому цілком можуть бути багато хто з вищеописаних помилок, які приведуть до проблем з індексацією сайту. Тому при перевірці robots.txt на помилки не варто покладатися лише на подібні автоматизовані інструменти – потрібно і самому все уважно перевіряти.