Содержание:

- Как обнаружить и исправить ошибки в файле robots.txt

- Самые частые ошибки файла robots.txt

- Принципы, которым нужно следовать, чтобы предотвратить ошибки в файле robots.txt

- Проверка robots.txt на ошибки

Как обнаружить и исправить ошибки в файле robots.txt

Каждый уважающий себя веб-мастер должен иметь хотя бы общее представление о том, как управлять процессом индексации страниц и файлов сайта в поисковых системах.

Не будем тянуть резину и сразу отметим, что для нахождения общего языка с поисковыми роботами достаточно правильно настроить robots.txt. Ключевое слово – «правильно». Ведь если допустить в robots.txt ошибки, последствия могут быть довольно неприятными.

Самые частые ошибки файла robots.txt

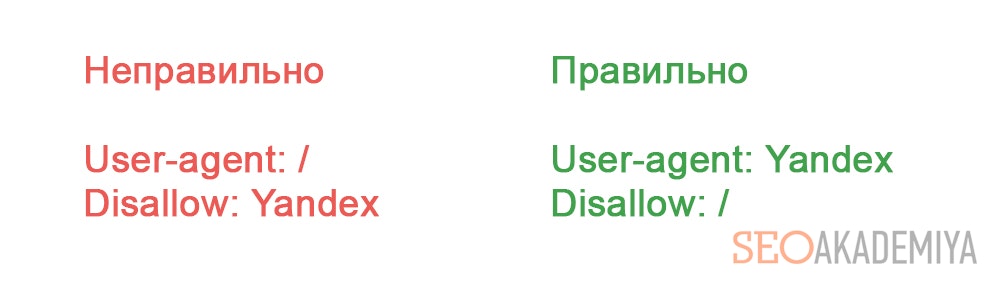

- Перепутанные значения директив (по незнанию или по недосмотру).

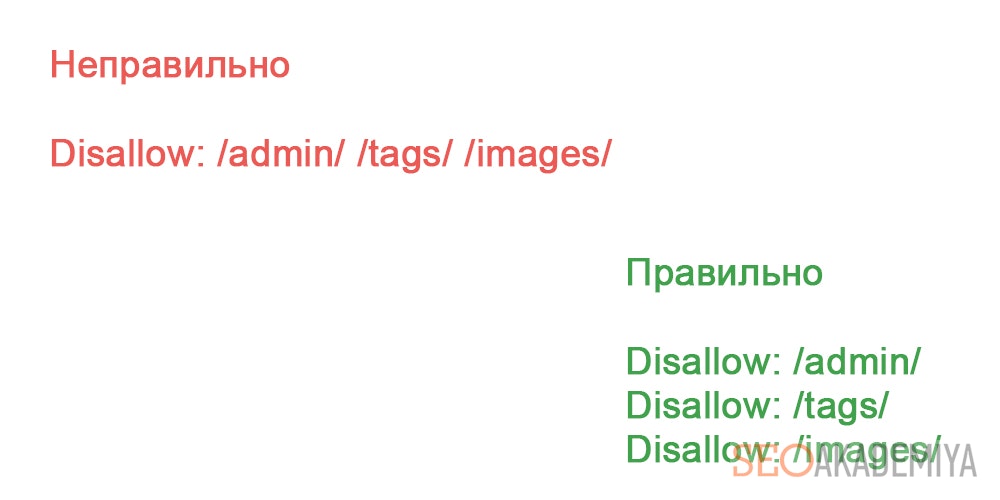

- Перечисление нескольких URL в одной директиве Disallow.

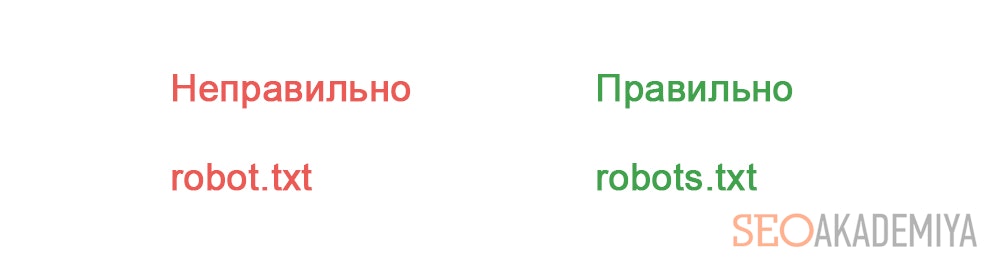

- Название файла robots.txt с ошибками.

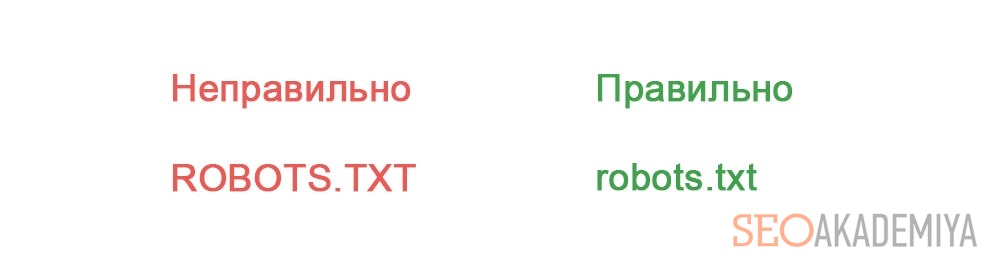

- В названии файла robots.txt присутствуют заглавные буквы.

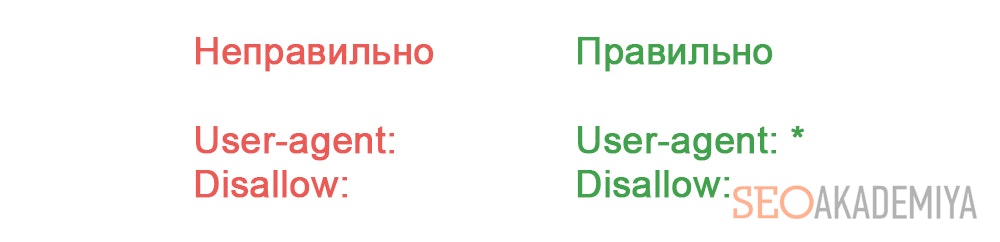

- Пустое поле в User-agent.

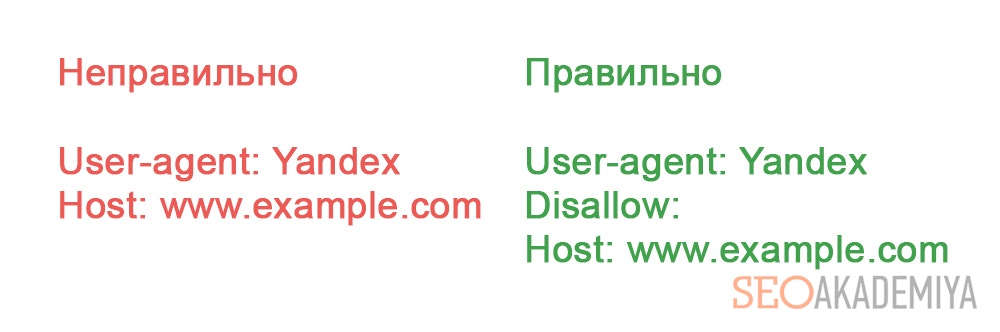

- Отсутствующая директива Disallow.

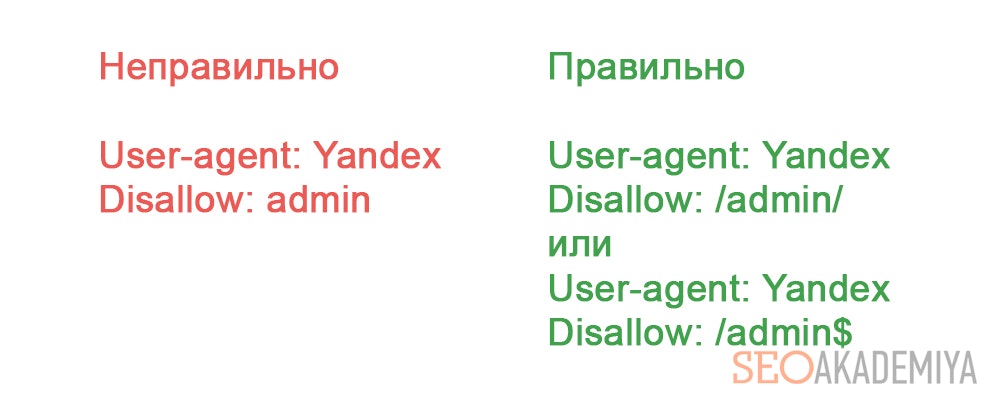

- Неправильный формат URL в директиве Disallow.Ошибка в файле robots.txt на левой половине скриншота приведет к тому, что от индексации будут закрыты все страницы и файлы, в начале URL которых содержится «admin».Все будет указано правильно, если использовать символы «$» и «/» для указания «разрыва».

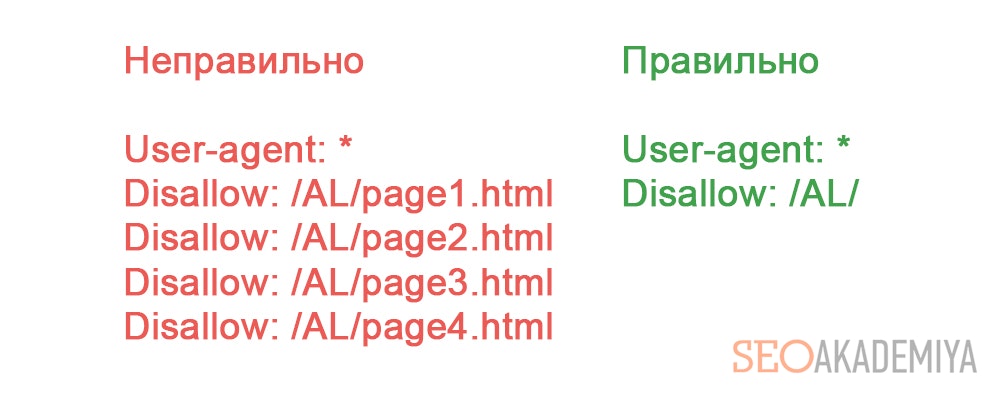

- Перечисление всех файлов директории. В принципе это не совсем ошибка. Просто рациональнее в этом случае закрыть от индексации всю директорию целиком.

Принципы, которым нужно следовать, чтобы предотвратить ошибки в файле robots.txt

- Прописанные в robots.txt директивы являются рекомендациями, которых придерживаются лишь роботы крупных поисковых систем. Сторонние боты чаще всего на них внимания не обращают. Поэтому их лучше блокировать по IP.

- Заблокированные в robots.txt страницы все еще продолжают быть доступными интернет-пользователям. Поэтому если цель – скрыть веб-страницу не только от роботов, но и от пользователей, на нее нужно установить пароль.

- Поддомены рассматриваются поисковиками как отдельные сайты. Поэтому рекомендации по их индексации следует прописывать в отдельных robots.txt в корне каждого поддомена.

- robots.txt нечувствителен к регистру. Поэтому директивы можно писать как строчными, так и прописными. Но имена файлов и директорий должны прописываться только так, как они выглядят в адресной строке браузера.

- Указанный в директиве User-agent реагирует на все указанные под ним директивы вплоть до следующей строки с User-agent. Поэтому не стоит надеяться, что директивы под вторым User-agent будут выполнены роботом, указанным в первом User-agent. Для каждого робота указания нужно дублировать.

Проверка robots.txt на ошибки

Чтобы проверить robots.txt на ошибки, проще всего воспользоваться предназначенными для этого инструментами от поисковых систем.

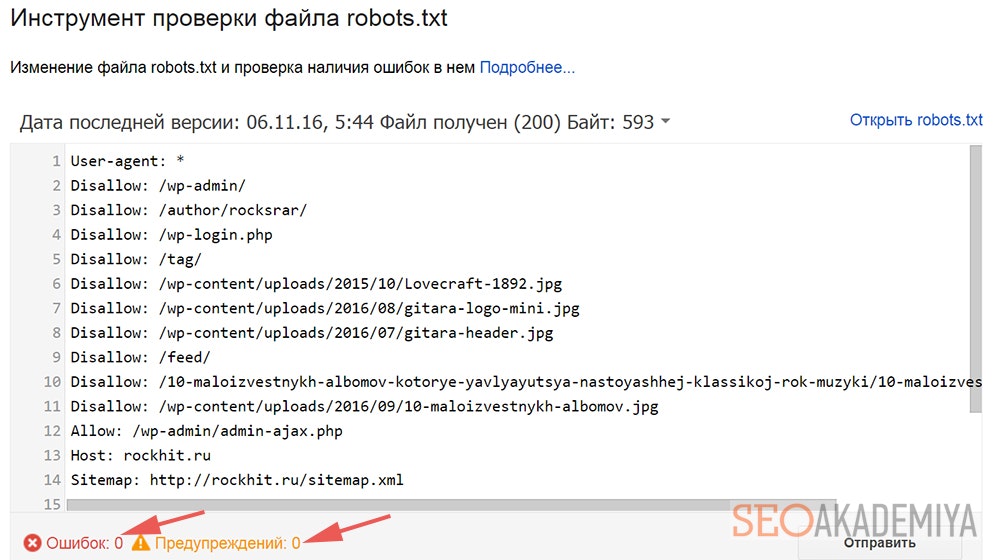

В случае с Google нужно зайти в Search Console/Сканирование и выбрать «Инструмент проверки файла robots.txt».

Под окном с содержимым искомого файла можно увидеть количество ошибок и предупреждений.

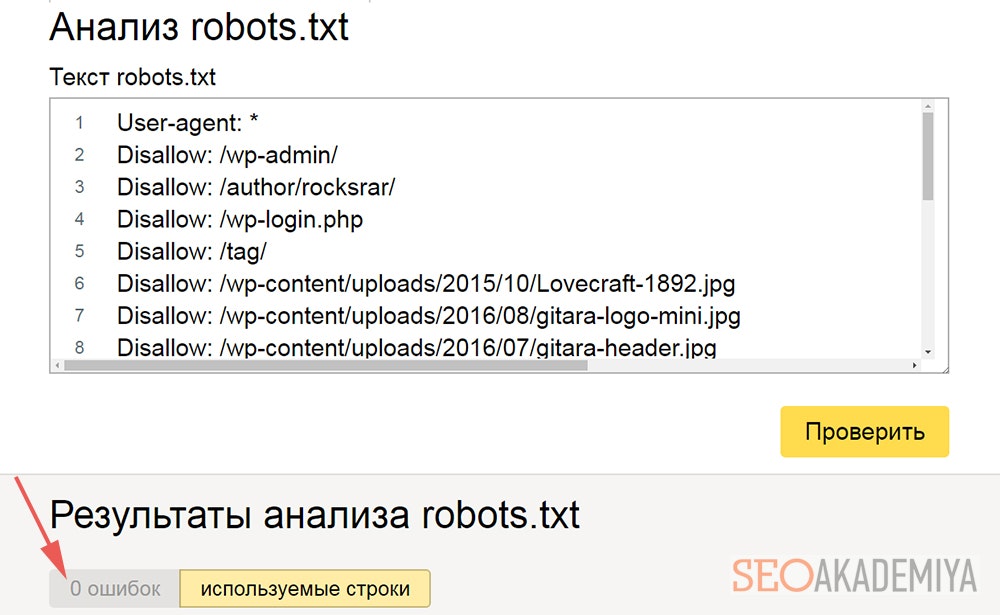

В Яндекс.Вебмастере имеется аналогичный функционал (Инструменты/Анализ robots.txt).

Также имеется возможность узнать, сколько в проверяемом robots.txt ошибок.

Правда, если обе проверки покажут, что ошибок нет, это еще не повод радоваться. Это лишь значит, что прописанные в файле инструкции соответствуют стандартам.

Но в нем вполне могут быть многие из вышеописанных ошибок, которые приведут к проблемам с индексацией сайта. Поэтому при проверке robots.txt на ошибки не стоит полагаться лишь на подобные автоматизированные инструменты – нужно и самому все внимательно проверять.

Павел Шульга

Павел Шульга