Содержание:

- Мета-тег robots поможет найти общий язык с поисковыми роботами

- Как воспользоваться возможностями мета-тега robots

- Особенности использования мета-тега robots

- Зачем нужен мета-тег robots, если есть файл robots.txt?

Мета-тег robots поможет найти общий язык с поисковыми роботами

Даже не зная, зачем нужен мета-тег robots, только исходя из его названия, уже можно сделать выводы о том, что он имеет какое-то отношение к роботам поисковых систем. И это действительно так.

Внедрение мета-тега robots в код веб-страницы дает возможность указать поисковым ботам свои пожелания по поводу индексирования ее содержимого и ссылок, расположенных на ней. Это может пригодится в многих ситуациях. Например, при наличии на сайте дублирования контента или для предотвращения передачи веса страничек по ссылкам, расположенным на них.

Пройдя seo интенсив в режиме онлайн, вы сможете не только правильно настроить этот и другие мета-теги, но и значительно улучшить видимость вашего сайта в поисковых системах.

Как воспользоваться возможностями мета-тега robots

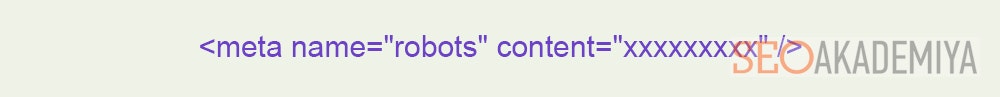

Страница, к которой нужно применить желаемые условия индексирования, должна содержать внутри тега <head> своего html-кода правильно оформленный мета-тег robots.

Структура его довольно проста:

Чтобы он был правильно воспринят ботами поисковиков, в данной конструкции содержимое атрибута content (‘’ххххххххх’’) должно состоять из одной или нескольких (через запятую) стандартных директив:

- index/noindex – указывает на необходимость индексации/игнорирования содержимого страницы.

- follow/nofollow – анализировать/игнорировать ссылки в пределах веб-страницы.

- all/none – индексировать/игнорировать страницу полностью.

- noimageindex – запрет индексации присутствующих на странице изображений.

- noarchive – запрет на вывод в результатах поиска ссылки «Сохраненная копия», которая дает возможность просматривать сохраненную в кэше поисковика копию страницы (даже если она временно недоступна или удалена с сайта).

- nosnippet – запрет на вывод в поисковой выдаче под названием страницы фрагмента текста (сниппета), описывающего ее содержание.

- noodp – директива, которая сообщает Google-боту о запрете использования в качестве сниппета страницы, описания из каталога Open Directory Project (он же DMOZ).

Особенности использования мета-тега robots

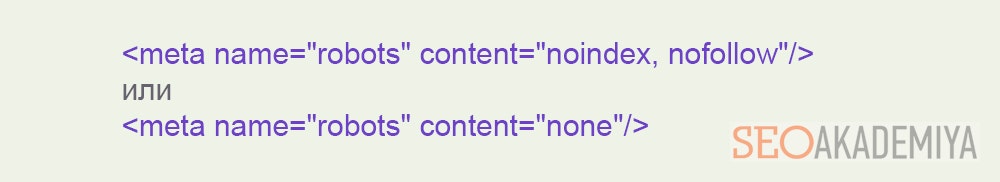

Некоторые поддерживаемый этим мета-тегом комбинации директив взаимозаменяемы (тождественны). Например, если нужно запретить индексирование содержимого странички и всех ссылок на ней, можно использовать в мета-теге robots ‘’noindex, nofollow’’ или же директиву ‘’none’’.

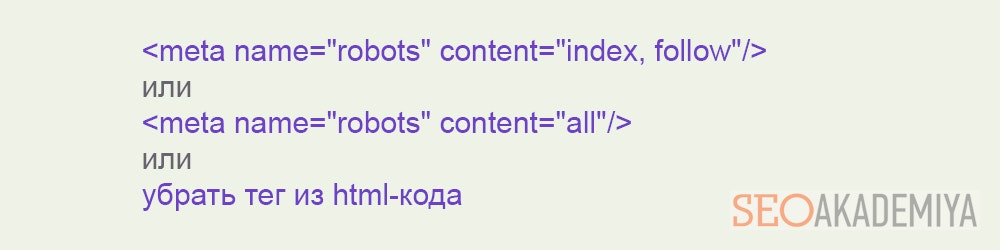

В обратном случае, когда нужно индексировать всё (в параметре content мета-тега robots – ‘’index, follow’’ или ‘’all’’), появляется еще и третий вариант – вообще не внедрять этот тег в код страницы.

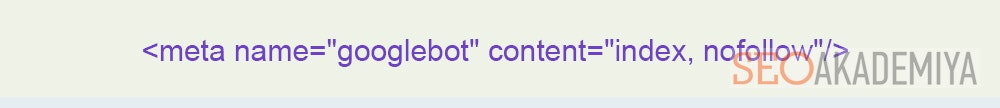

Бывают и частные случаи, в которых указания по поводу индексирования нужно сообщить только роботу какой-нибудь одной поисковой системы. Для этого нужно вместо ‘’robots’’ указать имя бота, которого касаются содержащиеся в мета-теге директивы. Например, если Google должен внести в свой индекс содержимое странички, но при этом не анализировать ссылки на ней:

Важно, чтобы в содержимом атрибута content не было повторений или присутствия противоречащих друг другу директив, поскольку в этом случае мета-тег может быть проигнорирован поисковым ботом.

Еще один момент, на почве которого довольно часто спорят веб-мастера – регистр, в котором прописывается содержимое мета-тега. Одни считают, что правильно использовать только прописные, другие – только строчные. Но на самом деле приемлемы оба варианта, поскольку мета-тег нечувствителен к регистру.

Зачем нужен мета-тег robots, если есть файл robots.txt?

Да, действительно на первый взгляд может показаться, что применение этого мета-тега предоставляет те же возможности, что и настройка файла robots.txt. Но несколько отличий все же есть. И они вполне могут быть причинами, чтобы отдать предпочтение использованию мета-тега:

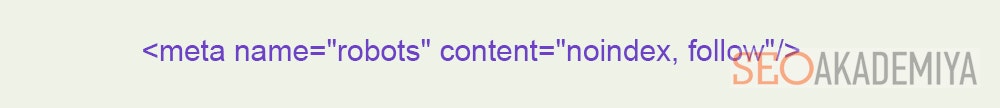

- Мета-тег robots используется для более тонкой настройки индексации – можно закрыть контент, но оставить открытыми ссылки (в параметре content мета-тега robots – ‘’noindex, follow’’) и наоборот. В robots.txt такой возможности нет.

- В ситуациях, когда нет возможности получить доступ к корневой директории веб-сайта, редактировать robots.txt не представляется возможным. Вот тогда-то и приходит на помощь одноименный мета-тег.

- В robots.txt можно закрыть от индексации целый каталог, чтобы запретить доступ ботов ко всем, содержащимся в нем страницам, тогда как мета-тег придется использовать для каждой из них. Получается, что в таком случае удобнее произвести настройки в файле. Но если некоторые страницы внутри каталога все же нужно оставить открытыми, удобнее использовать мета-тег.

Для управления индексацией страниц веб-сайта допустимо одновременно использовать мета-тег robots и файл robots.txt. Они могут отвечать за указания поисковым ботам по поводу разных веб-страниц или же дублировать команды друг друга.

А вот если в них будут присутствовать противоречащие директивы по поводу одних и тех же страниц, роботы поисковиков будут принимать не всегда верное решение – по умолчанию выбирается более строгое указание. Получается, что страницы (или ссылки на них), по поводу которых между robots.txt и мета-тегом robots имеются разногласия, индексироваться не будут.

Возможность управления индексацией веб-сайта – очень полезный инструмент для SEO-продвижения. Главное, научиться правильно определять, в какой ситуации эффективнее использовать тот или иной из теперь известных Вам способов.

Павел Шульга

Основатель и идейный лидер Академии SEO.Предприниматель, владелец 8-ми работающих бизнесов, создатель и спикер обучающих курсов Академии SEO. Практически всю свою осознанную жизнь занимается SEO-продвижением.

В 2004 году увлекся ...