зміст:

- Секрети мови robots.txt

- Види директив і особливості їх заповнення

- Як зробити Robots для Вордпресс: покрокова інструкція заповнення

- Як створити файл robots.txt в ВордПресс

- Створення документа robots.txt за допомогою текстових редакторів

- Створення robots.txt за допомогою плагіна для ВордПресс

- висновок

Секрети мови robots.txt

Файл robots.txt — важливий інструмент SEO-оптимізації сайту. У його завдання входить налагодження контакту з ботами пошукових систем і інформування їх про те, в які папки їм потрібно заглядати для сканування даних, а які потрібно обходити стороною.

Відразу слід сказати, що немає ідеального файлу robots.txt для WordPress, який підходив би всім без винятку сайтам на цій CMS. Але є базові речі, які можна коригувати в залежності від того, які сторінки сайту ви хочете відкрити або закрити для пошукових систем.

Що ж необхідно вказувати в robots.txt і як створити такий файл? Для початку слід зрозуміти, які команди в ньому міститися і як взагалі він « говорить » з ботами пошукових систем.

Основними складовими елементами файлу robots для WordPress є директиви і змінні дані, що вказують на файл ( групу файлів ).

Види директив і особливості їх заповнення

User-agent — називає ім'я пошукового робота, до якого звернені команди: Googlebot ( Googlebot-news, Googlebot-image і ін. ), Yandexbot ( YandexImages, YandexVideo і ін. ), Bing, Slurp, Mail. Для звернення до всіх ботів використовується символ * ( User-agent: *). Це головна директива файлу robots для WordPress, вона повинна знаходиться на самому початку файлу.

Allow і Disallow — відкриває і, відповідно, закриває доступ до файлів і сторінок сайту. Варто відразу обмовитися, що команди в robots.txt не примушують пошукових роботів до виконання, вони швидше настійно рекомендують. При цьому боти в праві вести себе так, як їм заманеться, і можуть сканувати навіть закриті від їхніх очей файли.

Для спілкування з ботами в файлі robots.txt застосовуються спеціальні оператори:

- * — будь-які символи до і після змінних даних.

- $ — як точка в кінці речення, цей символ показує, що стоїть перед ним знак є останнім в адресному рядку;

- # — позначає, що далі йдуть коментарі автора і вони не враховуються ПС;

- / — показує до яких розділів і сторінок відноситься вказівка.

Sitemap — вказує шлях до XML-file карти сайту. Зазвичай вказується в кінці файлу robots.txt. Стандартний вид посилання на карту сайту – https://domen.com/sitemap.xml, де domen.com – доменне ім'я Вашого сайту на WordPress. Sitemap.xml — назва файлу карти сайту.

Host — раніше використовувався пошуковими роботами Яндекса для визначення головного дзеркала сайту. Зараз ця директива втратила свою актуальність і вказувати її роботсе не потрібно. Роботами Google host ніколи і не враховувався.

Crawl-delay — задає часовий інтервал між процесами сканування. Її враховують Яндекс, Mail.ru, Bing і Yahoo! За розрахункову одиницю прийнята секунда, вона може позначатися цілим числом або у вигляді десяткового дробу з точкою в якості роздільника: 1.0, 0.7 і т. Д.

Clean-param — показує ботам Яндекса динамічні адреси зі знаком питання, які необхідно приховати, щоб уникнути дублювання контенту.

Як зробити Robots для Вордпресс: покрокова інструкція заповнення

Якщо ви хочете вказати різні умови для роботів Яндекса і Google, тоді слід прописувати директиви з командами для кожного з цих пошукових систем окремо. Якщо ж таку мету не переслідуєте, можете використовувати загальні правила, це означає, що в поле User-agent потрібно вказувати *.

Алгоритм написання правильного документа для WordPress robots.txt:

- Вказуємо адресата команд ( User-agent )

- Закриваємо від індексації ( Disallow ):

- файли адмінки;

- особисті кабінети, форми реєстрації та авторизації;

- інструменти роботи з замовленнями ( кошик, форми для заповнення даних і т. Д. );

- підходи до інтерактивних призначеним для користувача інтерфейсів ;

- папку cgi;

- дані по функціоналу пошуку;

- службові сторінки;

- дублюючі сторінки і розділи;

- дані про параметри фільтрації, порівняння і правил сортування;

- UTM-мітки;

- плагіни і графіку тим оформлення. - Відкриваємо ( Allow ) ті файли і документи, індексація яких необхідна, але вони знаходяться всередині вже закритих категорій, наприклад, зображення і JavaScript

- Вводимо дані карти сайту ( Sitemap )

- Якщо необхідно, прописуємо Crawl-Delay

- Якщо необхідно, прописуємо Clean-Param ( враховується тільки для Яндекс-ботів )

- Через сервіси Google і Яндекс перевіряємо правильність заповнення robots.txt

Начебто нічого складного немає, але досить часто виникає багато питань щодо того, які файли і папки варто закривати від сканування, а які бажано індексувати. В рамках онлайн-курсу SEO Ривок ми детально зупиняємося на цій темі, а в якості бонусу наші фахівці підкажуть, як у вашому випадку краще скласти файл robots.txt для вашого сайту на WordPress і перевірять його заповнення.

Як створити файл robots.txt в ВордПресс

Є кілька способів створити robots.txt для WordPress - вручну і за допомогою плагінів. Розглянемо їх докладніше.

Створення документа robots.txt за допомогою текстових редакторів

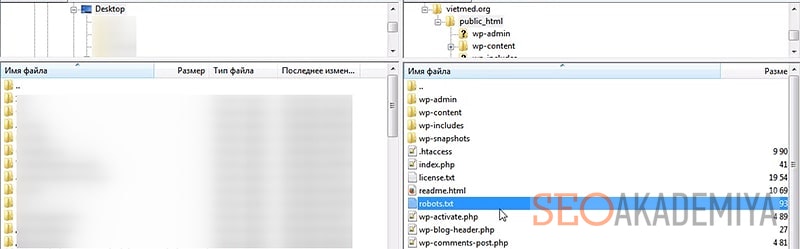

Для написання robots.txt застосуємо будь-який стандартний текстовий редактор, підійде той же Блокнот. Після того, як всі дані будуть внесені в документ, зберігаємо його на комп'ютері під ім'ям robots.txt. Залишилося помістити його на сервер WordPress.

Заходимо на FTP-сервер сайту, знаходимо папку public_html головного каталогу і перетягуємо в неї свій файл robots.txt. Все, пошукові боти бачать рекомендації для індексації.

Створення robots.txt за допомогою плагіна для ВордПресс

Розглянемо відразу два найбільш популярних плагіна для WP — Yoast SEO і All in One SEO Pack

- Yoast SEO

Після установки і активації плагіна переходимо в розділ Інструменти вкладки SEO і вибираємо Редактор файлів, далі натискаємо Створити файл robots.txt. На сторінці, що відкрилася можна складати список команд для ботів пошукових систем або редагувати існуючі дані. Після перевірки правильності заповнення зберігаємо зміни.

- All in One SEO Pack

По завершенні установки плагіна All in One для WordPress з метою створення файлу robots.txt заходимо в розділ Управління модулями, вибираємо іконку robots.txt і тиснемо Activate. У відкрилася формі вводимо додаткові правила або видаляємо ( робимо неактивними ) раніше додані команди. Редактор самостійно розставляє директорії по місцях, вводити назву директорій не потрібно.

Відмітна особливість All in One SEO Pack — настроюється блокування шкідливих ботів, які перевантажують сайт, не приносячи вам ніякої користі.

висновок

Незалежно від обраного способу створення файлу robots.txt, якщо все директорії і команди внесені коректно, пошукові боти бачитимуть його і в більшості випадків слідувати зазначеним рекомендаціям. Після завантаження файлу рекомендуємо перевірити його за допомогою сервісів Яндекс.Вебмастер і Google Search Console. Зверніть увагу, при перевірці в Google будуть вказані помилки в специфічних командах для Яндекса або інших систем, які він не розуміємо. Не звертайте на це уваги.

Тепер ви знаєте, як зробити файл robots.txt для ВордПресс і зможете направити стопи пошукових роботів в потрібному вам напрямку, полегшивши навантаження на сайт і оптимізувавши процес індексації даних на сторінках вашого сайту.