Содержание:

- Секреты языка robots.txt

- Виды директив и особенности их заполнения

- Как сделать Robots для Вордпресс: пошаговая инструкция заполнения

- Как создать файл robots.txt в ВордПресс

- Создание документа robots.txt с помощью текстовых редакторов

- Создание robots.txt с помощью плагина для ВордПресс

- Заключение

Секреты языка robots.txt

Файл robots.txt — важный инструмент SEO-оптимизации сайта. В его задачу входит налаживание контакта с ботами поисковых систем и информирование их о том, в какие папки им нужно заглядывать для сканирования данных, а какие требуется обходить стороной.

Сразу следует сказать, что нет идеального файла robots.txt для WordPress, который подходил бы всем без исключения сайтам на этой CMS. Но есть базовые вещи, которые можно корректировать в зависимости от того, какие страницы сайта вы хотите открыть или закрыть для поисковых систем.

Что же необходимо указывать в robots.txt и как создать такой файл? Для начала следует понять, какие команды в нём содержаться и как вообще он «говорит» с ботами поисковых систем.

Основными составными элементами файла robots для WordPress являются директивы и переменные данные, указывающие на файл (группу файлов).

Виды директив и особенности их заполнения

User-agent — называет имя поискового робота, к которому обращены команды: Googlebot (Googlebot-news, Googlebot-image и др.), Yandexbot (YandexImages, YandexVideo и др.), Bing, Slurp, Mail.ru. Для обращения ко всем ботам используется символ * (User-agent: *). Это главная директива файла robots для WordPress, она должна находится в самом начале файла.

Allow и Disallow — открывает и, соответственно, закрывает доступ к файлам и страницам сайта. Стоит сразу оговориться, что команды в robots.txt не принуждают поисковых роботов к выполнению, они скорее настоятельно рекомендуют. При этом боты в праве вести себя так, как им вздумается, и могут сканировать даже закрытые от их глаз файлы.

Для общения с ботами в файле robots.txt применяются специальные операторы:

- * — любые символы до и после переменных данных.

- $ — как точка в конце предложения, этот символ показывает, что стоящий перед ним знак является последним в адресной строке;

- # — обозначает, что далее идут комментарии автора и они не учитываются ПС;

- / — показывает к каким разделам и страницам относится указание.

Sitemap — указывает путь до XML-file карты сайта. Обычно указывается в конце файла robots.txt. Стандартный вид ссылки на карту сайта – https://domen.com/sitemap.xml, где domen.com – доменное имя Вашего сайта на WordPress. Sitemap.xml — название файла карты сайта.

Host — ранее использовался поисковыми роботами Яндекса для определения главного зеркала сайта. Сейчас эта директива потеряла свою актуальность и указывать ее роботсе не нужно. Роботами Google host никогда и не учитывался.

Crawl-delay — задает временной интервал между процессами сканирования. Её учитывают Яндекс, Mail.ru, Bing и Yahoo! За расчетную единицу принята секунда, она может обозначаться целым числом или в виде десятичной дроби с точкой в качестве разделителя: 1.0, 0.7 и т. д.

Clean-param — показывает ботам Яндекса динамические адреса со знаком вопроса, которые необходимо скрыть во избежание дублирования контента.

Как сделать Robots для Вордпресс: пошаговая инструкция заполнения

Если вы хотите указать разные условия для роботов Яндекса и Google, тогда следует прописывать директивы с командами для каждого из этих поисковиков отдельно. Если же такую цель не преследуете, можете использовать общие правила, это означает, что в поле User-agent нужно указывать *.

Алгоритм написания правильного документа для WordPress robots.txt:

- Указываем адресата команд (User-agent)

- Закрываем от индексации (Disallow):

- файлы админки;

- личные кабинеты, формы регистрации и авторизации;

- инструменты работы с заказами (корзина, формы для заполнения данных и т. д.);

- подходы к интерактивным пользовательским интерфейсам ;

- папку cgi;

- данные по функционалу поиска;

- служебные страницы;

- дублирующие страницы и разделы;

- данные о параметрах фильтрации, сравнения и правил сортировки;

- UTM-метки;

- плагины и графику тем оформления. - Открываем (Allow) те файлы и документы, индексация которых необходима, но они находятся внутри уже закрытых категорий, например, изображения и JavaScript

- Вводим данные карты сайта (Sitemap)

- Если необходимо, прописываем Crawl-Delay

- Если необходимо, прописываем Clean-Param (учитывается только для Яндекс-ботов)

- Через сервисы Google и Яндекс проверяем правильность заполнения robots.txt

Вроде бы ничего сложного нет, но достаточно часто возникает много вопросов относительно того, какие файлы и папки стоит закрывать от сканирования, а какие желательно индексировать. Наши онлайн seo курсы подробно освещают эту тему, а в качестве бонуса специалисты в поддержке подскажут, как лучше составить файл robots.txt для вашего сайта на WordPress и проверят его заполнение.

Как создать файл robots.txt в ВордПресс

Есть несколько способов создать robots.txt для WordPress - вручную и с помощью плагинов. Рассмотрим их подробнее.

Создание документа robots.txt с помощью текстовых редакторов

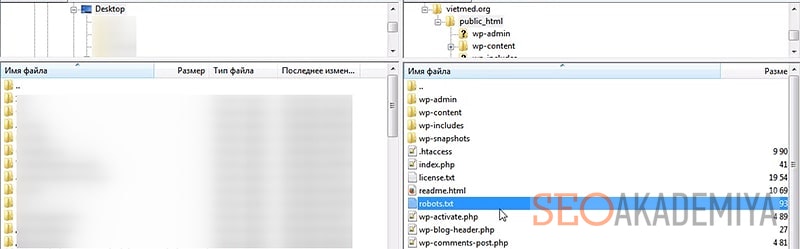

Для написания robots.txt применим любой стандартный текстовый редактор, подойдёт тот же Блокнот. После того, как все данные будут внесены в документ, сохраняем его на компьютере под именем robots.txt. Осталось поместить его на сервер WordPress.

Заходим на FTP-сервер сайта, находим папку public_html главного каталога и перетаскиваем в нее свой файл robots.txt. Всё, поисковые боты видят рекомендации для индексации.

Создание robots.txt с помощью плагина для ВордПресс

Рассмотрим сразу два наиболее популярных плагина для WP — Yoast SEO и All in One SEO Pack

- Yoast SEO

После установки и активации плагина переходим в раздел Инструменты вкладки SEO и выбираем Редактор файлов, далее нажимаем Создать файл robots.txt. На открывшейся странице можно составлять список команд для ботов поисковых систем или редактировать существующие данные. После проверки правильности заполнения сохраняем изменения.

- All in One SEO Pack

По завершении установки плагина All in One для WordPress с целью создания файла robots.txt заходим в раздел Управление модулями, выбираем иконку robots.txt и жмём Activate. В открывшейся форме вводим дополнительные правила или удаляем (делаем неактивными) ранее добавленные команды. Редактор самостоятельно расставляет директории по местам, вводить название директорий не требуется.

Отличительная особенность All in One SEO Pack — настраиваемая блокировка вредоносных ботов, которые перегружают сайт, не принося вам никакой пользы.

Заключение

Вне зависимости от выбранного способа создания файла robots.txt, если все директории и команды внесены корректно, поисковые боты будут видеть его и в большинстве случаев следовать указанным рекомендациям. После загрузки файла рекомендуем проверить его с помощью сервисов Яндекс.Вебмастер и Google Search Console. Обратите внимание, при проверке в Google будут указаны ошибки в специфических командах для Яндекса или других систем, которые он не понимаем. Не обращайте на это внимания.

Теперь вы знаете, как сделать файл robots.txt для ВордПресс и сможете направить стопы поисковых роботов в нужном вам направлении, облегчив нагрузку на сайт и оптимизировав процесс индексации данных на страницах вашего сайта.

Павел Шульга

Основатель и идейный лидер Академии SEO.Предприниматель, владелец 8-ми работающих бизнесов, создатель и спикер обучающих курсов Академии SEO. Практически всю свою осознанную жизнь занимается SEO-продвижением.

В 2004 году увлекся ...